Estrarre parole dalle immagini nell’era digitale: alcune osservazioni sull’Ocr storico

Federico Boschetti

English abstract

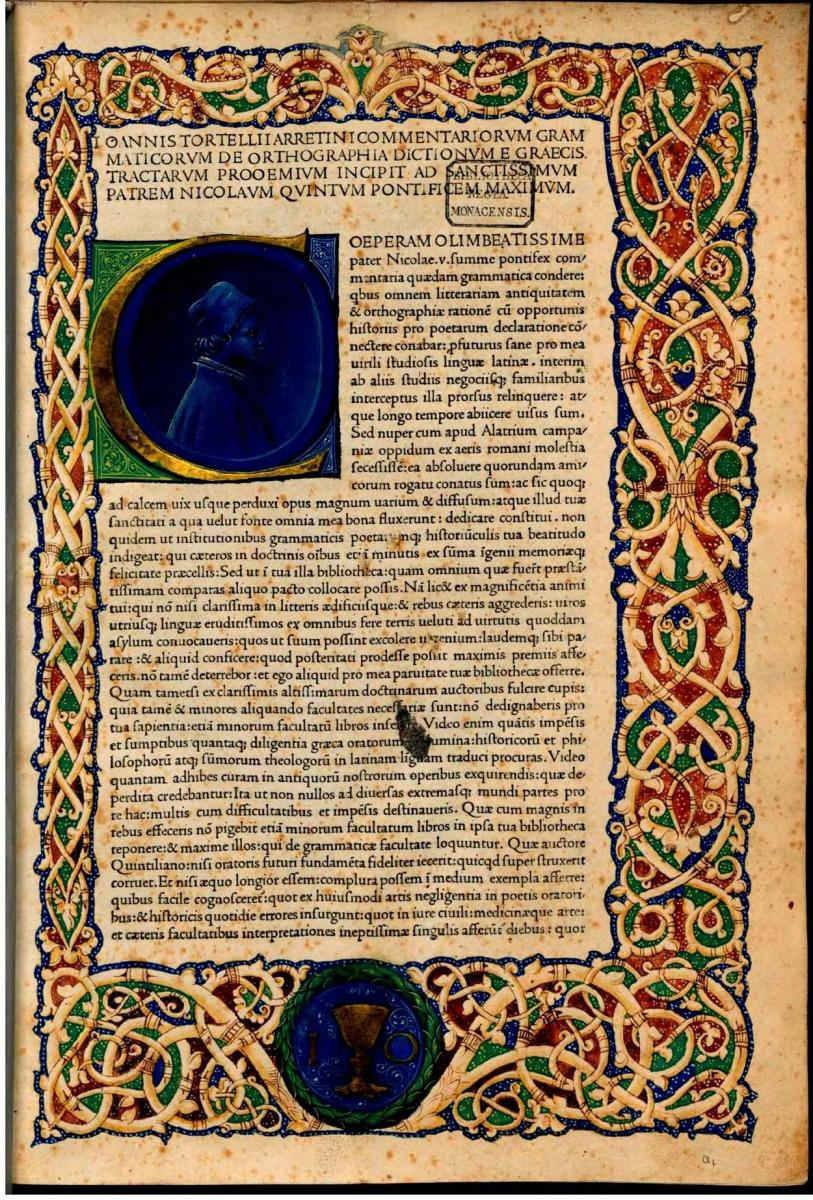

Giovanni Tortelli, Orthographia Graeca, Venezia 1471. Fonte online.

1. Introduzione

Estrarre parole in modo automatico o semi-automatico dalle immagini è un’attività determinante nell’era digitale, perché le operazioni che si possono eseguire sul testo digitale sono diverse e complementari rispetto alle azioni che si possono eseguire sull’immagine da cui tale testo proviene. L’immagine della pagina di un libro a stampa, ad esempio, può essere ingrandita, ruotata, schiarita, ritagliata. Tuttavia il suo contenuto testuale, leggibile (più o meno facilmente) da parte di un essere umano, non è immediatamente disponibile al calcolatore per essere copiato, incollato e riformattato tramite applicazioni di videoscrittura, per essere individuato tramite la ricerca di parole chiave, per essere usato nella costruzione di indici e concordanze. Per estrarre il contenuto testuale, utilizzabile da una macchina, dal suo correlato visivo costituito dalla fotografia digitale della pagina, fruibile solo da un lettore umano, è necessario quindi applicare all’immagine procedure di riconoscimento automatico dei caratteri a stampa (optical character recognition: Ocr), procedure di riconoscimento automatico dei grafemi scritti a mano (handwriting recognition: si veda ad esempio Nielsen 2015), oppure procedure di riconoscimento di parole ad alta frequenza non segmentabili in unità inferiori (word spotting: si veda Rath, Manmatha 2003). In questa panoramica accessibile anche ai non addetti ai lavori, pur facendo cenno all’handwriting recognition e al word spotting, ci focalizzeremo soprattutto sull’Ocr, e in particolare sul riconoscimento ottico dei caratteri applicato a testi a stampa rilevanti per il classicista e per lo storico.

2. Dall’immagine al testo

Le grandi iniziative di digitalizzazione (manuale o semiautomatica) ad accesso libero di testi storici e letterari sono ormai giunte a maturazione, per quanto riguarda la copertura degli autori presi in considerazione: si pensi fra i molti altri al Gutenberg Project

3. L’Ocr generico

Le immagini delle pagine di edizioni a stampa fornite da queste iniziative, nella maggior parte dei casi, sono di qualità medio-alta. HathiTrust, inoltre, fornisce alle istituzioni consorziate (quindi non a libero accesso) immagini ad altissima risoluzione (sopra i 600 dot per inch: dpi, il livello di risoluzione correntemente maggiormente impiegato ai fini dell’Ocr). Le immagini fornite solitamente sono state automaticamente trasformate in bianco e nero, in base al livello di soglia ottimale (binarization), ruotate in modo che le righe di testo siano parallele alla base dell’immagine (deskewing), stirate in modo da minimizzare la deformazione dovuta alla rilegatura (dewarping), in modo da aumentare la leggibilità. Ciò che invece è qualitativamente molto variabile è il testo digitale, fornito in vari formati insieme alle immagini: come plain text, come testo mappato sull’immagine all’interno di un documento .pdf, come file contenente le coordinate delle parole sull’immagine (solitamente in .xml). La qualità del testo digitalizzato è variabile perché le immagini vengono trattate con sistemi di Ocr generici, non ottimizzati per situazioni che richiedono trattamenti specifici.

4. L’Ocr storico

Per questo motivo l’Ocr storico costituisce un campo di ricerca in rapida espansione (Piotrowski 2012). Mentre sistemi per l’Ocr commerciali, applicati a documenti a stampa recenti nelle maggiori lingue europee, raggiungono ormai livelli di accuratezza così alti da non richiedere quasi più la correzione manuale, se applicati ad edizioni Sette-ottocentesche mostrano forti limiti. La specificità di questi documenti è data da molteplici fattori: l’invecchiamento della carta, la variabile qualità degli inchiostri, le differenti tecniche di impressione, che possono aver generato sbavature, etc.

5. Intervenire sulle immagini

Se le immagini non sono disponibili in collezioni online, o se quelle disponibili non sono soddisfacenti ai fini dell’Ocr, è necessario acquisire nuove immagini, magari da esemplari differenti della stessa edizione già presente online, ma in uno stato di conservazione migliore. In tal caso, si devono ottimizzare le nuove immagini con le tecniche di binarization, deskewing, etc. viste sopra e si deve valutare se sia il caso di applicare un despeckling (letteralmente: ‘smacchiamento’) più aggressivo. Tale procedura automatica serve ad individuare, all’interno dell’immagine, figure corpuscolari di dimensioni inferiori agli elementi isolati che costituiscono un carattere a stampa (operativamente: macchioline con un’area inferiore a quella del punto fermo o del puntino sulla ‘i’).

6. L’Ocr del greco antico

Il contenuto testuale delle edizioni critiche dei classici greci è particolarmente difficile da acquisire, perché il greco antico è politonico, a differenza del greco moderno trattato comunemente da applicazioni commerciali; perché le edizioni critiche sono poliglotte, visto che il metalinguaggio dell’apparato critico è solitamente il latino e i nomi degli studiosi o i titoli delle opere citate sono in varie lingue europee; perché l’apparato critico è in corpo minore, aumentando la difficoltà di riconoscimento. Per questi motivi il Perseus Project della Tufts University di Medford (MA, USA), l’Open Philology Project dell’Università di Lipsia

7. Tecniche per migliorare l’accuratezza dell’Ocr

In via sperimentale, si è dimostrato che l’allineamento dei risultati di molteplici sistemi di Ocr, applicati alle stesse immagini del testo, può essere utile per migliorare l’accuratezza del risultato finale, se si applicano degli adeguati criteri di selezione ai risultati parziali discordanti (Boschetti et al. 2009). Tali criteri si basano sulla scelta di sequenze di caratteri che trovino riscontro in repertori di forme flesse esistenti nella lingua greca. Le tecniche di allineamento sono mutuate dalla bioinformatica, in quanto il procedimento per allineare sequenze testuali è del tutto analogo a quello che si applica alle sequenze di Dna.

8. Rischi di contaminazione fra edizioni

Quando si è in presenza di molteplici edizioni, di cui almeno una sia già stata corretta manualmente, si può applicare una strategia più aggressiva di auto-correzione (cioè di correzione automatica senza supervisione da parte di un esperto) mediante allineamento. Facendo corrispondere fra di loro le sequenze di caratteri di due edizioni diverse, una delle quali da correggere e l’altra certamente corretta, è possibile sostituire automaticamente parole contenenti caratteri errati con parole provenienti dall’altra edizione. È chiaro che il rischio di contaminazione fra edizioni diverse è molto alto, in quanto la parola identificata come un errore, potrebbe essere semplicemente una variante accolta a ragione dall’editore del testo, ma non presente nella lista delle forme flesse a nostra disposizione.

9. I modelli linguistici

Per questo gli errori auto-corretti con questa tecnica devono essere limitati a casi speciali, quando la differenza fra la sequenza che si suppone errata e la sequenza candidata per l’auto-correzione è di un solo carattere, tale da generare una successione di suoni impronunciabile per una parola greca (ad esempio, tau seguito da delta). È importante quindi avere a disposizione o costruire nuovi modelli linguistici per le lingue o per le varietà linguistiche in esame. Ai fini dell’auto-correzione dell’Ocr e della valutazione dell’accuratezza raggiunta, è importante avere a disposizione almeno un modello sillabico, per stabilire quali sequenze di caratteri producono catene sillabiche ben formate in greco, per la valutazione di nomi propri e di varianti ortografiche non ancora acquisiti nelle basi di dati a disposizione, e un modello morfologico per la valutazione delle forme flesse. Dopo la revisione manuale dei testi digitalizzati, grazie all’arricchimento del corpus testuale, anche le liste di forme flesse hanno la possibilità di essere incrementate con nuovi nomi propri o con nuove varianti ortografiche e morfologiche.

10. L’Ocr su incunabula

Più le edizioni a stampa sono antiche, più il riconoscimento è difficile, fino alla punta estrema rappresentata dagli incunabula. Grazie al lavoro di Uwe Springmann (Springmann et al. 2014) e del CIS group

11. L’handwriting recognition e il word spotting

Per completezza, vale la pena accennare ad altri campi di ricerca che coinvolgono l’estrazione di informazioni testuali dalle immagini. Affine all’Ocr, ma molto più complesso per la difficoltà di segmentare i grafemi e per la variabilità degli stessi, è il riconoscimento della scrittura manuale. L’handwriting recognition allo stato dell’arte sfrutta tecniche di deep learning, basate sull’impiego di reti neurali, per la classificazione dei grafemi scritti a mano (si veda ad esempio Nielsen 2015). Anche su testi a stampa, quando l’Ocr non dà risultati soddisfacenti, in particolare a causa della difficoltà di segmentare i glifi, si può applicare con successo, almeno per le parole a più alta frequenza e quindi con un maggior numero di campioni all’interno del testo, la tecnica del word spotting, cioè del riconoscimento della parola come blocco unico, come se fosse un monogramma.

12. La correzione collaborativa

Allo stato attuale, il riconoscimento automatico non raggiunge ancora i livelli di accuratezza di un correttore di bozze esperto. Per questo i testi digitalizzati automaticamente hanno bisogno di un delicato e costoso (in termini di tempo e, di conseguenza, di denaro) lavoro di revisione. Nei paragrafi successivi vedremo alcune pratiche di correzione collaborativa, che stanno producendo risultati di rilievo o quanto meno promettenti.

13. WikiSource

Una delle più diffuse applicazioni web per la correzione collaborativa di testi digitalizzati è WikiSource

14. La correzione dell’Ocr come esperienza didattica

La correzione collaborativa, almeno nella nostra esperienza (Rizzetto et al. 2017) può avere una tangibile valenza didattica. Il progetto sul ritorno del greco in occidente nel XV secolo, coordinato da Paola Tomè, ci ha dato l’opportunità di coinvolgere più di quaranta studenti di licei classici del veneto, per la correzione dell’Ocr applicato da Uwe Springmann all’incunabulum dell’Orthographia graeca di Giovanni Tortelli, 1471. Gli studenti hanno dimostrato di aver colto da un lato l’importanza di contribuire all’arricchimento di risorse digitali utili non soltanto a fini didattici, ma anche di ricerca e dall’altro il valore di confrontarsi direttamente con la rappresentazione digitale della fonte primaria, senza la mediazione dell’editore contemporaneo.

15. Studiare l’ergonomia dei sistemi di correzione collaborativa

La correzione collaborativa stessa può diventare oggetto di studio, al fine di comprendere quali siano i modi migliori per disporre il testo e l’immagine, per catturare l’attenzione del correttore in caso di probabile presenza di errore, etc. Abbiamo attivato una collaborazione con il Centro Interdipartimentale di Progettazione e Ricerca di Ateneo ‘Scienza Nuova’ dell’Università Suor Orsola Benincasa di Napoli

16. Conclusione

Si conclude qui questo breve excursus sull’estrazione del testo dalle immagini tramite Ocr e tecniche affini. Migliorare l’accuratezza dell’Ocr storico è molto importante in questa delicata fase di passaggio dalla stampa al digitale perché, come in tutti i passaggi di supporto, ciò che sarà lasciato da parte o ciò che riceverà un trattamento non adeguato, rischia di andare perduto o di essere trasmesso con guasti insanabili (si veda sull’argomento Roncaglia 2010).

Bibliografia

- Almas et al. 2011

B. Almas, A. Babeu, D. Bamman, F. Boschetti, L. Cerrato, G. R. Crane, B. Fuchs, D. Mimno, B. Roberston, D. Smith, Towards Dynamic Variorum Editions, white paper, 2011. - Boschetti et al. 2009

F. Boschetti, M. Romanello, A. Babeu, D. Bamman, G. R. Crane, Improving OCR Accuracy for Classical Critical Editions, in M. Agosti, J. Borbinha, S. Kapidakis, C. Papatheodorou, G. Tsakonas (eds), Research and Advanced Technology for Digital Libraries. ECDL 2009. Lecture Notes in Computer Science, vol. 5714. Springer, Berlin, Heidelberg 2009, 156-167. - Nielsen 2015

M. A. Nielsen, Neural Networks and Deep Learning, s.l., 2015. - Piotrowski 2012

M. Piotrowski, Natural Language Processing for Historical Texts, Toronto 2012. - Rath, Manmatha 2003

T. M. Rath, R. Manmatha, Features for Word Spotting in Historical Manuscripts in Proc. of the 7th Int'l Conf. on Document Analysis and Recognition (ICDAR), Edinburgh, Scotland, August 3-6, 2003, vol. 1, 218-222. - Rizzetto et al. 2017

M. Rizzetto, A. Trevisiol, D. Falcone, N. Pilon, P. Tomè, F. Boschetti, E. Bighin, U. Springmann, Nuove frontiere delle Digital Humanities in classe: esperienze dal campo, in F. Boschetti (ed.), Book of Abstracts AIUCD 2016, Firenze 2017, 119-122. - Robertson et al. 2014

B. Robertson, C. Dalitz, F. Schmitt, Automated page layout simplification of Patrologia Graeca, in Proceedings of the First International Conference on Digital Access to Textual Cultural Heritage (DATeCH '14). ACM, New York, NY, USA 2014, 167-172. - Roncaglia 2010

G. Roncaglia, La quarta rivoluzione: sei lezioni sul futuro del libro, Bari 2010. - Springmann et al. 2014

U. Springmann, D. Najock, H. Morgenroth, H. Schmid, A. Gotscharek, F. Fink, OCR of historical printings of Latin texts: problems, prospects, progress, in Proceedings of the First International Conference on Digital Access to Textual Cultural Heritage (DATeCH '14). ACM, New York, NY, USA 2014, 71-75.

English abstract

This article discusses techniques and practices aimed at the extraction of textual content from images related to printed editions. Optical Character Recognition (Ocr) applied to scholarly editions of classical texts or applied to early printed editions is a challenging task, due to material issues, such as the bad quality of papers damaged by time, or due to linguistic issues, such as the lack of linguistic models suitable to a specific linguistic variety. This article illustrates some common strategies aimed at improving historic Ocr accuracy, such as the alignment of the textual sequences generated by different Ocr engines and the incremental enrichment of suitable linguistic models. Finally, some practices of collaborative Ocr proof-reading are described and discussed.

keywords | Optical Character Recognition; Classical texts; Early printeed editions.

Per citare questo articolo / To cite this article: F. Boschetti, Estrarre parole dalle immagini nell’era digitale: alcune osservazioni sull’Ocr storico, “La rivista di Engramma” n. 150 vol. 1, ottobre 2017, pp. 185-192 | PDF